生活支援ロボットの研究開発

- 工学部 メカトロニクス工学科担当

- 教授 小谷 信司 (准教授 渡辺 寛望)

- ホームページ »

- 山梨大学研究者総覧へ »

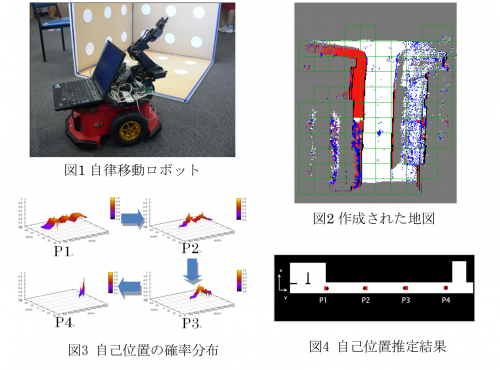

生活をより豊かにするために、カメラや各種センサを用いて生活を支援するロボットを研究開発しています。図1に研究に利用している自律移動ロボットPioneerを示します。Pioneerにカメラや測距センサなどを搭載して、自動的に作成したキャンパス内の地図を図2に示します。白は通路平面、青は通過の際に悪影響を与える段差、黒は壁等の通過できない段差、赤は通路平面とは異なる凸平面、灰が未探索領域です。図2のような段差情報を含んだ地図を用いることによって、より安全な経路をナビゲーションすることができます。

ナビゲーションの際にはどこにいるのかを正確に把握することが重要です。屋外ではGPSなどが利用できますが、屋内ではGPSの電波が受信できないため、地図情報とセンサ情報を用いて自己位置を推定します。図3は、自己位置の確率分布を示しています。P1からP4にロボットが移動するに従って、自己位置が1箇所に集中しています。図4は推定位置を地図上にプロットした結果です。黒丸がロボットの位置、赤い四角が推定した位置を示しており、P4では一致しています。さらに、地図作成時に人が通行した場合も、人を検出することによって、人の部分のみを地図から削除することが可能です。図5に人検出結果を示します。緑が壁を示し、青点が人の部分に集まっています。青点の中にある赤丸が検出した人の位置です。人の部分を削除した壁の形状を地図情報として保存します。

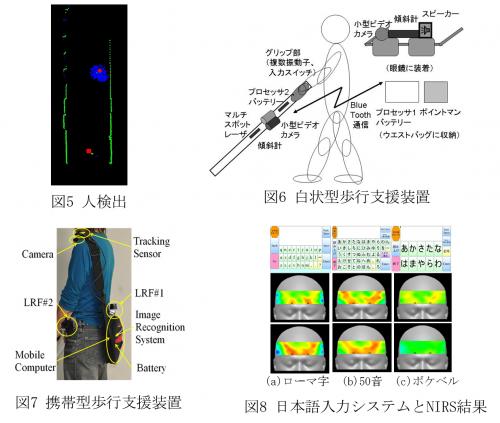

生活支援ロボットの1例として、視覚障害者の安全な歩行を支援する装置を研究開発しています。図6、7は視覚障害者向け携帯型歩行支援装置です。バッグに小型カメラや測距センサを取り付けて目的地までの誘導や、白杖にマルチスポットレーザを取り付け、従来の白杖では届かなかった距離の3次元情報の獲得、下り段差や下り階段の検出を行っています。

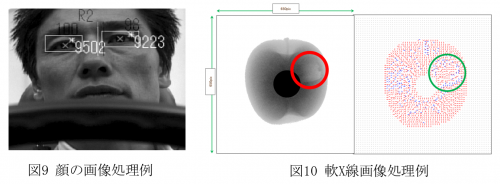

発話や書字が行えない肢体不自由者のコミュニケーションを実現するために、視線による日本語入力システムを研究開発しています。図8に研究開発した3種類の入力方式と、各方式を用いて視線により文字を入力した際の脳のヘモグロビン濃度変化を示します。ポケベル方式は、脳の活動が安静時に近く、無理なく入力できることが示されています。

画像処理・画像認識の技術を適用して、自動車を運転しているドライバの集中力評価や虫食い被害を受けた果実の検出を行っています。運転中のドライバの顔の3次元位置・方位、視線方向、まばたきの頻度を検出して、集中力の評価を行います。果実の正常部分と被害部分(空洞)のX線の吸収率の違いを利用して、目視では不可能な被害果の検出を実現しています。